读取MongoDB的数据导入到HDFS

1)编写配置文件

[jason@hadoop102 datax]$ vim job/mongdb2hdfs.json { "job": { "content": [ { "reader": { "name": "mongodbreader", "parameter": { "address": ["127.0.0.1:27017"], "collectionName": "jason", "column": [ { "name":"name", "type":"string" }, { "name":"url", "type":"string" } ], "dbName": "test", } }, "writer": { "name": "hdfswriter", "parameter": { "column": [ { "name":"name", "type":"string" }, { "name":"url", "type":"string" } ], "defaultFS": "hdfs://hadoop102:9000", "fieldDelimiter": " ", "fileName": "mongo.txt", "fileType": "text", "path": "/", "writeMode": "append" } } } ], "setting": { "speed": { "channel": "1" } } } }

2)mongodbreader参数解析

address: MongoDB的数据地址信息,因为MonogDB可能是个集群,则ip端口信息需要以Json数组的形式给出。【必填】

userName:MongoDB的用户名。【选填】

userPassword: MongoDB的密码。【选填】

collectionName: MonogoDB的集合名。【必填】

column:MongoDB的文档列名。【必填】

name:Column的名字。【必填】

type:Column的类型。【选填】

splitter:因为MongoDB支持数组类型,但是Datax框架本身不支持数组类型,所以mongoDB读出来的数组类型要通过这个分隔符合并成字符串。【选填】

3)执行

[jason@hadoop102 datax]$ bin/datax.py job/mongdb2hdfs.json

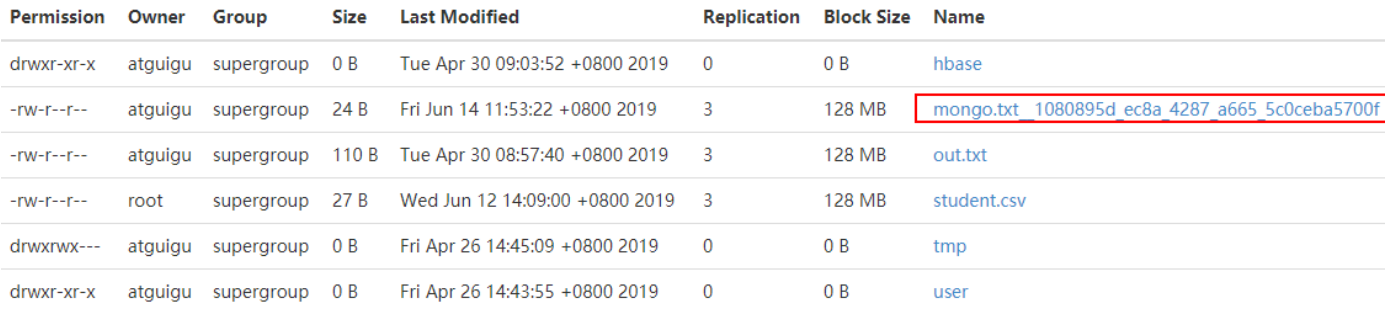

4)查看结果