(for pursue, do accumulation)

个人笔记,纯属佛系分享,如有错误,万望赐教。

蒙特卡洛(Monte Carlo, MC)方法是一种不基于模型的方法。它不需要具有完备的环境知识,只要求具备经验,即来自于真实的或模拟的环境交互过程中的样本序列({mathcal{S},mathcal{A},mathcal{R}})。

同时,MC方法是基于平均采样回报来解决强化学习问题,只针对幕式任务。

1. 预备知识

1.1 MC预测

MC方法是根据经验进行估计,即对访问该状态后观测到的回报求均值,随着观测到的回报越来越多,均值会逐渐收敛于期望值。

MC方法又可以分为首次访问型MC方法(first-visit MC method)和每次访问型MC方法(every-visit MC method):

首次访问型MC方法用首次访问状态(s)得到的回报均值估计(v_pi(s));

每次访问型MC方法用所有访问状态(s)得到的回报均值估计(v_pi(s))。

根据大数定律(law of large numbers),当对(s)的访问次数趋向无穷时,两种方法的估计值都会收敛于(v_pi(s))。

MC方法没有完备的环境模型,因此,将对状态的访问改为对“状态-动作”二元组的访,也就是说它估计的是(q_pi(s,a))而不是(v_pi(s))。

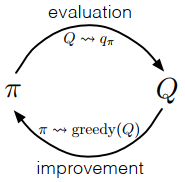

1.2 MC控制

MC方法也是用策略迭代算法进行控制,但更新的是(q_pi(a|s))。

和DP相同,选择贪心策略需要满足

策略改进通过将(q_{pi_k})对应的贪心策略作为(pi_{k+1})进行,满足策略改进定理,即

2. MC方法

MC方法可以分成同步策略(on-policy)方法和异步策略(off-policy)方法,它们的区别:

同步策略方法用于生成决策轨迹的策略和进行评估或改进的策略是相同的;

异步策略方法用于生成决策轨迹的策略和进行评估或改进的策略是不同的。

2.1 同步策略方法

在同步策略方法中,策略是“软性(soft)”的,即对任意(s in mathcal{S},a in mathcal{A}(s)),都有(pi(a|s)>0)。最典型的同步策略方法是(varepsilon)-贪心策略((varepsilon)-greedy policy),即多数时候会选择具有最大估计动作价值的动作,但有(varepsilon)的概率随机选择一个动作,该策略可以被表示为

根据策略改进定理,对于一个(varepsilon)-软性策略(pi),任何一个根据(q_pi)生成的(varepsilon)-贪心策略都是对它的一个改进。假设(pi^prime)是一个(varepsilon)-贪心策略,即

2.2 异步策略方法

所有的学习控制方法都面临一个困境:它们试图学习最优动作价值,但为了探索所有的动作,以此保证找到最优动作,它们需要尝试那些非最优的动作。

同步策略方法只是提出了一个妥协的办法——它并不是学习最优策略的动作价值,而是学习一个近似最优且仍能进行探索的策略的动作价值。

而异步策略方法则是使用两个不同的策略,一个用于学习并最终达到最优的目标策略(target policy),另一个更具探索性,并能生成决策序列的行为策略(behavior policy)。

异步策略方法使用了重要性采样(详见附录A),根据在目标策略和行为策略生成的轨迹的相对概率(即重要性采样比)对回报值加权。

假设目标策略为(pi),行为策略为(b(pi

eq b))。然后,给定一个起始状态(S_t),后续的“状态-动作”轨迹(A_t,S_{t+1},A_{t+1},...,S_T)在任意策略(pi)下的概率为

(p)为状态转移概率函数。可以得到重要性采样比为

由此可以看出,(

ho)只与策略(pi),(b)和样本序列有关,与MDP的动态特性无关。

下面通过一批观察得到的遵循策略(b)的episodes来估计(v_pi(s))。定义时间步长集合(mathcal{T}(s))在首次访问型方法下,包含所有访问过状态(s)的时间步长;在首次访问型方法,只包含在episode内首次访问状态(s)的时间步长。用(T(t))表示时刻t后的首次终止时刻,(G_t)表示(t)到(T(t))之间的回报值,(left{

ho_{t: T(t)-1}

ight}_{t in mathcal{T}(s)})表示相应的重要性采样比。

那么可以得出,普通重要性采样为(V(s) doteq frac{sum_{t in mathcal{T}(s)} ho_{t: T(t)-1} G_{t}}{|mathcal{T}(s)|})

加权重要性采样为(V(s) doteq frac{sum_{t in mathcal{T}(s)} ho_{t: T(t)-1} G_{t}}{sum_{t in mathcal{T}(s)} ho_{t: T(t)-1}})(若分母为(0),(V(s)=0))

关于价值函数的更新,可以通过增量式实现(详见附录B)。假设有一个回报序列(G_1,G_2,...,G_{n-1}),它们都是从相同的状态开始,且每一个回报都对应一个权重(W_i),则可以定义

假设前(n)个回报对应的权重累加和为(C_n),则(V_n)的更新方式为

附录

A. 重要性采样

重要性采样(importance sampling)主要作用是通过一个简单的可预测分布区估计一个服从另一个分布的随机变量的均值。

在重要性采样中,随机变量服从的分布不同但其元素的集合相同。因此,假设变量(A_1 sim P),(A_2 sim Q),其中(P={p_1,p_2,...,p_n}),(Q={q_1,q_2,...,q_n})。离散随机变量(A_1)可以写成(A={x_1,x_2,...,x_n}),其每个元素出现的概率都对应分布(P);同样,(A_2)可以写出(A={x_1,x_2,...,x_n}),其每个元素出现的概率都对应分布(Q)。则(mathbb{E}[A_1]= displaystyle sum^n_{i=1}x_ip_i),(mathbb{E}[A_2]= displaystyle sum^n_{i=1}x_iq_i)。

经过N次试验后,用MC估计得到它们的均值(overline{A}_1=frac{1}{N} displaystyle sum_{i=1}^{N} x_{i} K_{i}),(overline{A}_2=frac{1}{N} displaystyle sum_{i=1}^{N} x_{i} M_{i})((K_i)和(M_i)分别表示(x_i)在两次试验中出现的次数,所以(displaystyle sum_i K_i=sum_i M_i=N)),根据大数定律,当试验次数(N

ightarrow infty)时,统计均值是期望的无偏估计。

了解基本原理后,现在考虑如何运用。假设现在只能做关于(A_2)的试验,但又想估计(A_1)的均值,那么只需要将(K_i)替换为(M_i)。当试验次数(N ightarrow infty)时,(K_i approx Np_i),(K_i approx Np_i),可以推出(K_i approx M_i frac{p_i}{q_i})。因此,(A_1)的均值估计可以写为(overline{A}_1=frac{1}{N} displaystyle sum_{i=1}^{N} (x_{i}frac{p_i}{q_i}) M_{i})。

上述内容为普通重要性采样(ordinary importance sampling),但这只对(K_i)做了近似处理,(displaystyle sum_i frac{p_i}{q_i} M_{i})并非严格等于(N),会导致无界的方差,即无论(N)多大,普通重要性采样的估计值方差始终不会趋向于(0)。为了解决这个问题,进行了加权处理,就有了加权重要性采样(weighted importance sampling),只需将试验次数(N)替换成估计的试验次数(displaystyle sum_i frac{p_i}{q_i} M_{i}),则可得

(frac{p_i}{q_i})为重要性采样比(importance-sampling ratio)。普通重要性采样的估计是无偏的,而加权重要性采样的估计是有偏的且偏差逐渐收敛为(0);普通重要性采样方差无界,而加权重要性采样估计的方差仍能收敛于(0)。

B. 增量式实现

(转载请标明出处:https://www.cnblogs.com/HughCai/p/12810839.html)

References

Richard S. Sutton and Andrew G. Barto. Reinforcement Learning: An Introduction (Second Edition). Cambridge, Massachusetts London, England : The MIT Press, 2018.

Csaba Szepesvári, ‘Algorithms for Reinforcement Learning’, Synthesis Lectures on Artificial Intelligence and Machine Learning, vol. 4, no. 1, pp. 1–103, Jan. 2010, doi: 10.2200/S00268ED1V01Y201005AIM009.

UCL Reinforcement Learning Course by David Silver:https://www.bilibili.com/video/BV1b7411y7ax