Ik分词器能有效的帮助我们对词语进行各种方式的拆分,还可以根据自定义设置完成对词语的拆分,是搜索引擎不可或缺的一部分。接下来就详细的介绍一下Ik分词器的配置过程

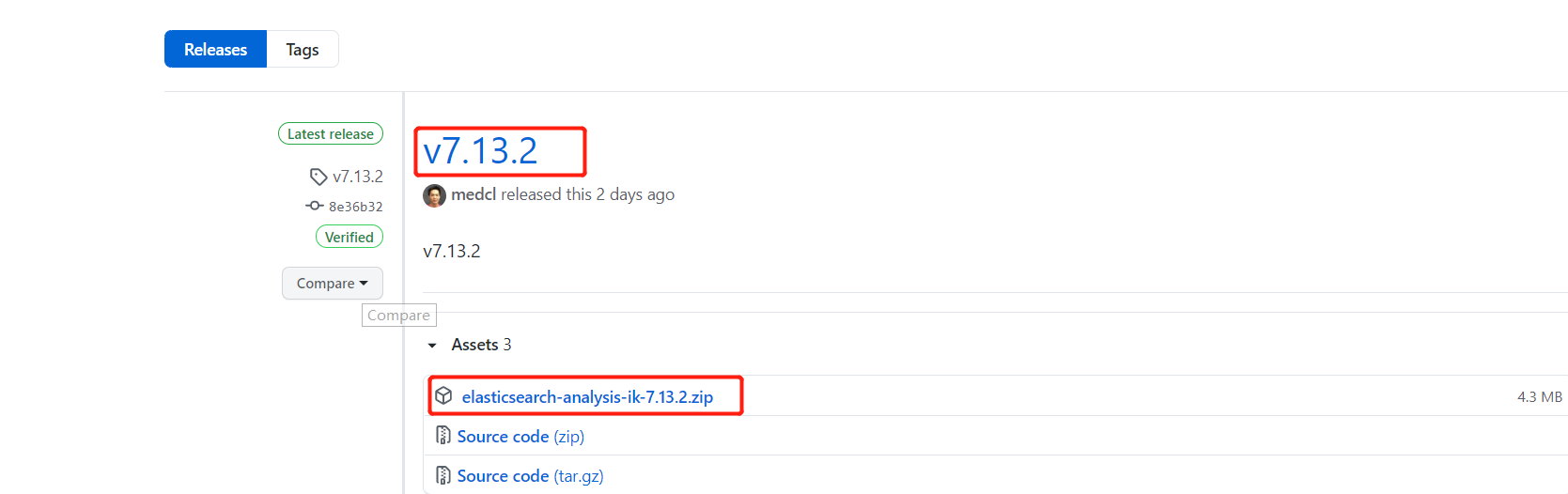

1.在github上查看Ik分词器的版本 https://github.com/medcl/elasticsearch-analysis-ik/

先复制对应版本的连接,在docker中进行下载

2.进入到Es容器中

docker exec -it elasticesearch /bin/bash #也可以根据镜像Id

3.在Es对应的plugins下创建ik文件夹并下载ik分词器

mkdir ik #创建文件夹 cd ik wget https://github.com/medcl/elasticsearch-analysis-ik/releases/download/v7.13.2/elasticsearch-analysis-ik-7.13.2.zip #下载到ik文件夹下 unzip elasticsearch-analysis-ik-7.13.2.zip #解压即可

4.重启Es

docker restart elasticsearch #重启Es

docker logs -f elasticearch #查看日志是否报错

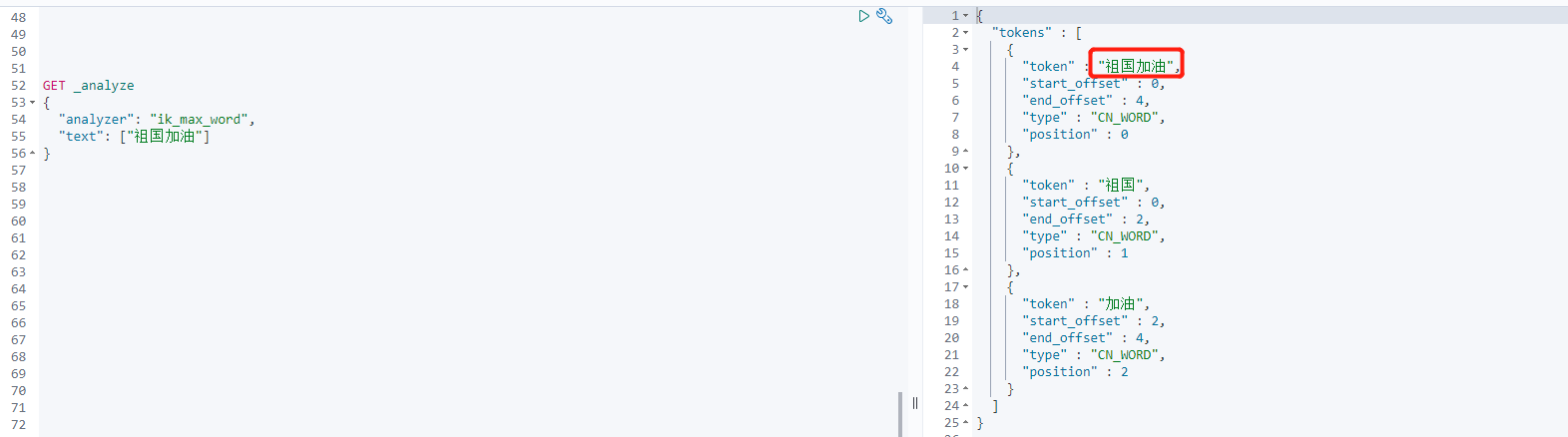

5.小试牛刀

6.配置自定义字典

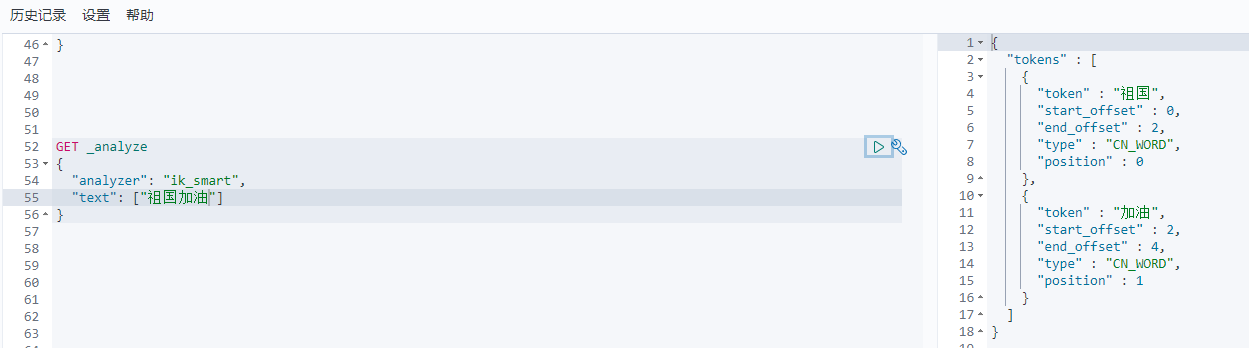

上边的这个祖国加油,我们想让它作为一个完整的词汇去查询,但ik分词器总是会把它拆分成祖国和加油。当然我们可以定义我们自己的字典把它当做一个完整的词汇。

在ik/config/IKAnalyzer.cfg.xml 进行配置

<entry key="ext_dict">mydict.dic</entry>

在ik/config下创建mydict.dic文件并录入自定义的词汇重启Es即可