原文链接:https://mp.weixin.qq.com/s/RO3FrPxhK2GEoDCGE9DXrw

在各种内部模型上观察到速度提升1.13~3.04倍。

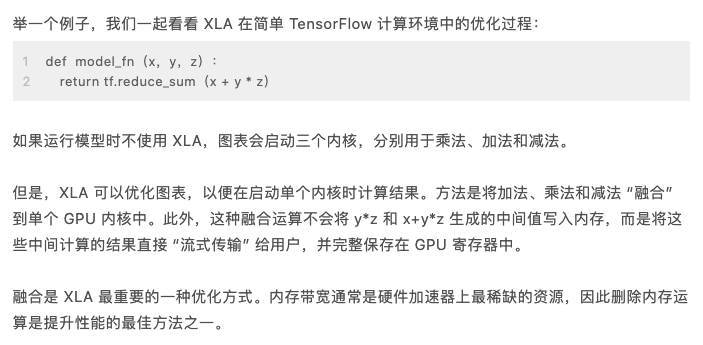

通常情况下,当您运行 TensorFlow 图表时,所有运算都由 TensorFlow 图表执行器单独执行。每个运算都会安装由图表执行器分派的预编译 GPU 内核(随附于 TensorFlow 二进制文件中)。

XLA 提供了另一种运行 TensorFlow 模型的模式:这种模式会将您的 TensorFlow 图表编译成专为您的模型生成的 GPU 内核序列。由于这些是您程序独有的内核,因此它们可以利用模型的特定信息进行优化。