1.用Hive对爬虫大作业产生的文本文件(或者英文词频统计下载的英文长篇小说)进行词频统计。

因为python生成的结果为中文,所以我下载了英文长篇小说是《Just A Girl》,下载完更改名字为girl.txt方便操作。

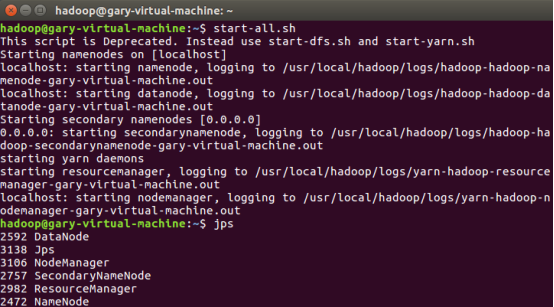

首先启动hadoop:

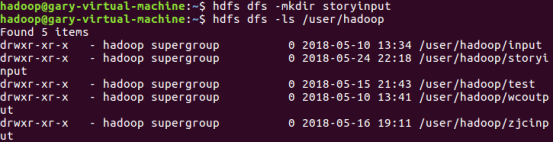

Hdfs上创建文件夹:

文件上传到hdfs:

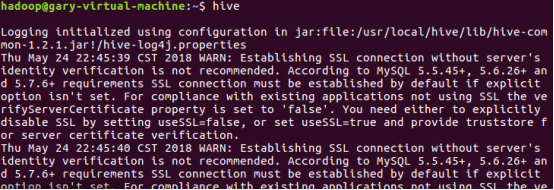

启动hive:

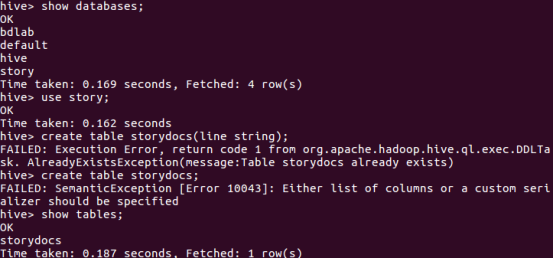

创建数据库story,在数据库里建原始文档表:

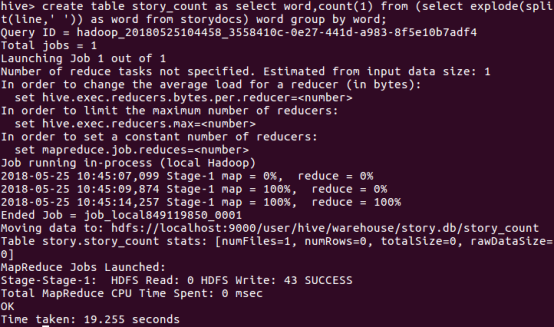

创建数据表story_count,然后进行HQL词频统计,结果放到story_count中:

查看story_count表,不知道为什么成功了显示不出来。

2.用Hive对爬虫大作业产生的csv文件进行数据分析,写一篇博客描述你的分析过程和分析结果。

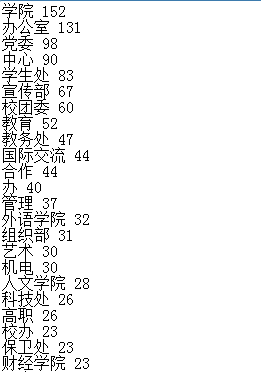

统计的是广州番禺职业技术学院校园要闻发布方的统计。如图:

将文件转换为csv格式和txt格式,并将文件放入到虚拟机中:

查看前十条:

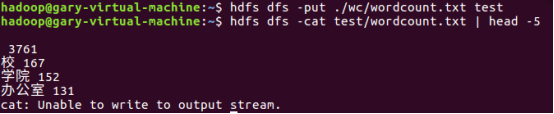

将文件上传至hdfs并显示前5条:

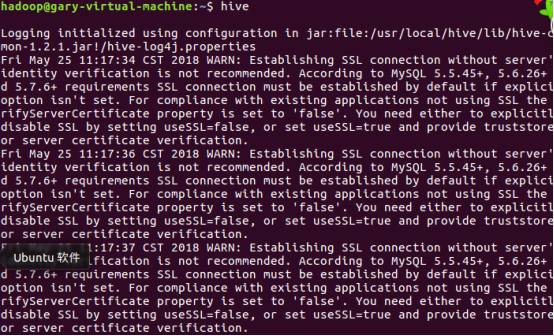

启动hive:

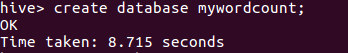

创建数据库mywordcount:

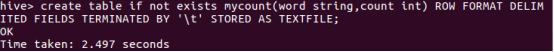

创建表:

将文件导入表中:

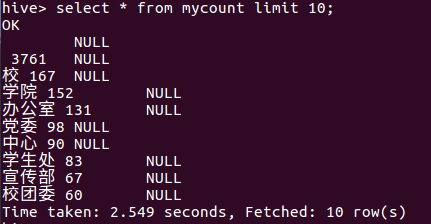

查看前十条: