1.将日志产生程序写入crontab中:

crontab -e

#每一分钟执行一次 */1 * * * * /home/qian/data/project/log_generator.sh

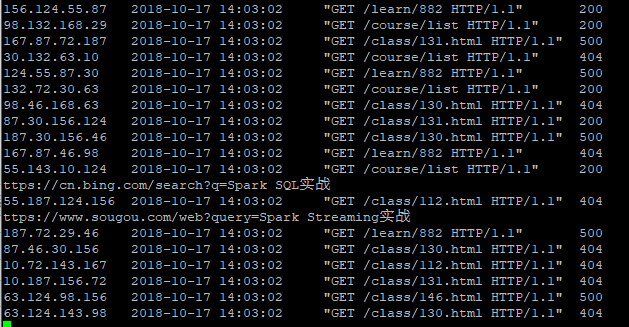

进入logs日志文件中:tail -f access.log

定时脚本添加成功

2.开启ZK:

zkServer.sh start

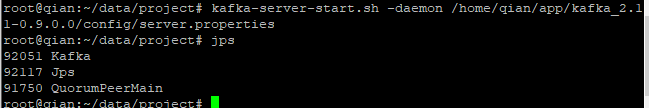

3.开启kafka-server:

kafka-server-start.sh -daemon /home/qian/app/kafka_2.11-0.9.0.0/config/server.properties

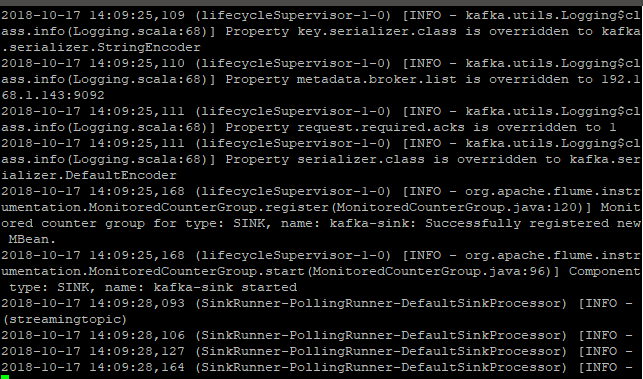

3.开启flume agent:

flume-ng agent --name exec-memory-kafka --conf $FLUME_HOME/conf/ --conf-file ~/data/project/streaming_project2.conf -Dflume.root.logger=INFO,console

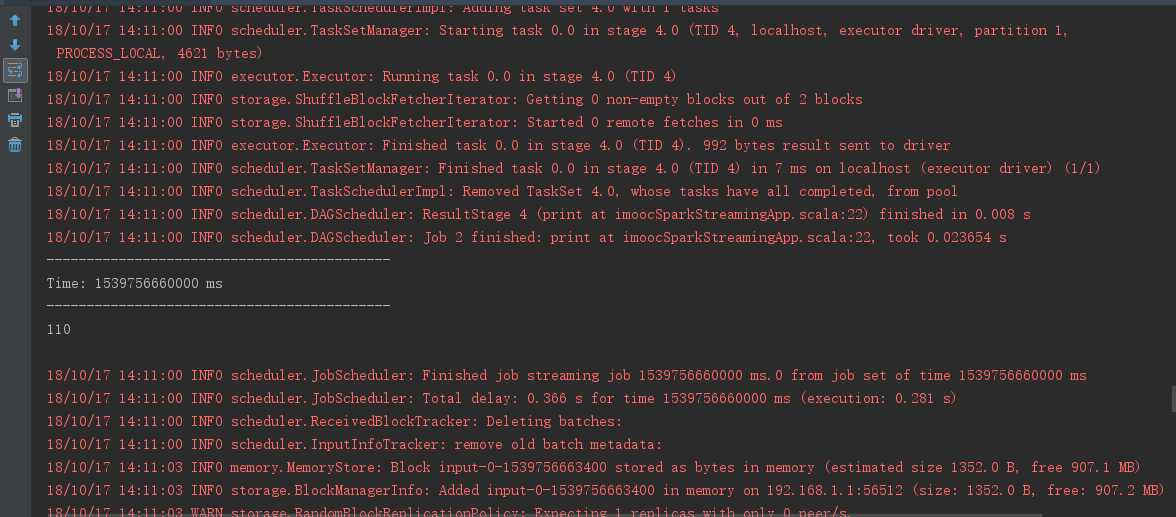

4.开启sparkstremaing(只做了简单的计数操作):

(1)在IDEA中执行scala代码,控制台如下:

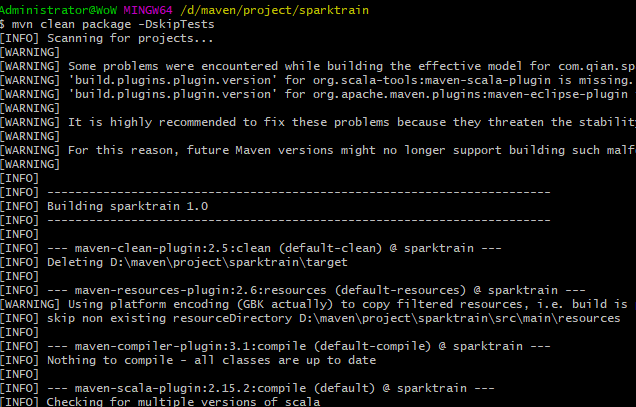

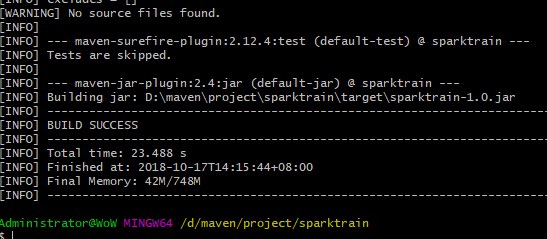

(2)在git-bash中打成jar包:

mvn clean package -DskipTests

(3)打包成功上传到服务器上:

(4)在服务器上运行上传的jar包。