这周的任务是:用python爬取美天全国的疫情数据,然后可视化;

刚开始的时候就上网查找相关爬取的知识点,听取了学长的意见:python的学习相对于java简单,然后就开始下载了关于python的相关软件;

前两节课主要是讲课,后两节课用来安装python的软件,先安装了python-3.6.5-amd64.exe

链接:https://pan.baidu.com/s/1w8kNNjbqWns6K9JDKamvlg 提取码:1grn

安装好之后我就我就安装了编译器pycharm,安装的时候遇见了很多的问题(所遇见的问题跟解决方法https://www.cnblogs.com/1234yyf/p/12491998.html),然后我的安装跟网上查找的能力有限,所以这两节课的主要就是用来安装软件;

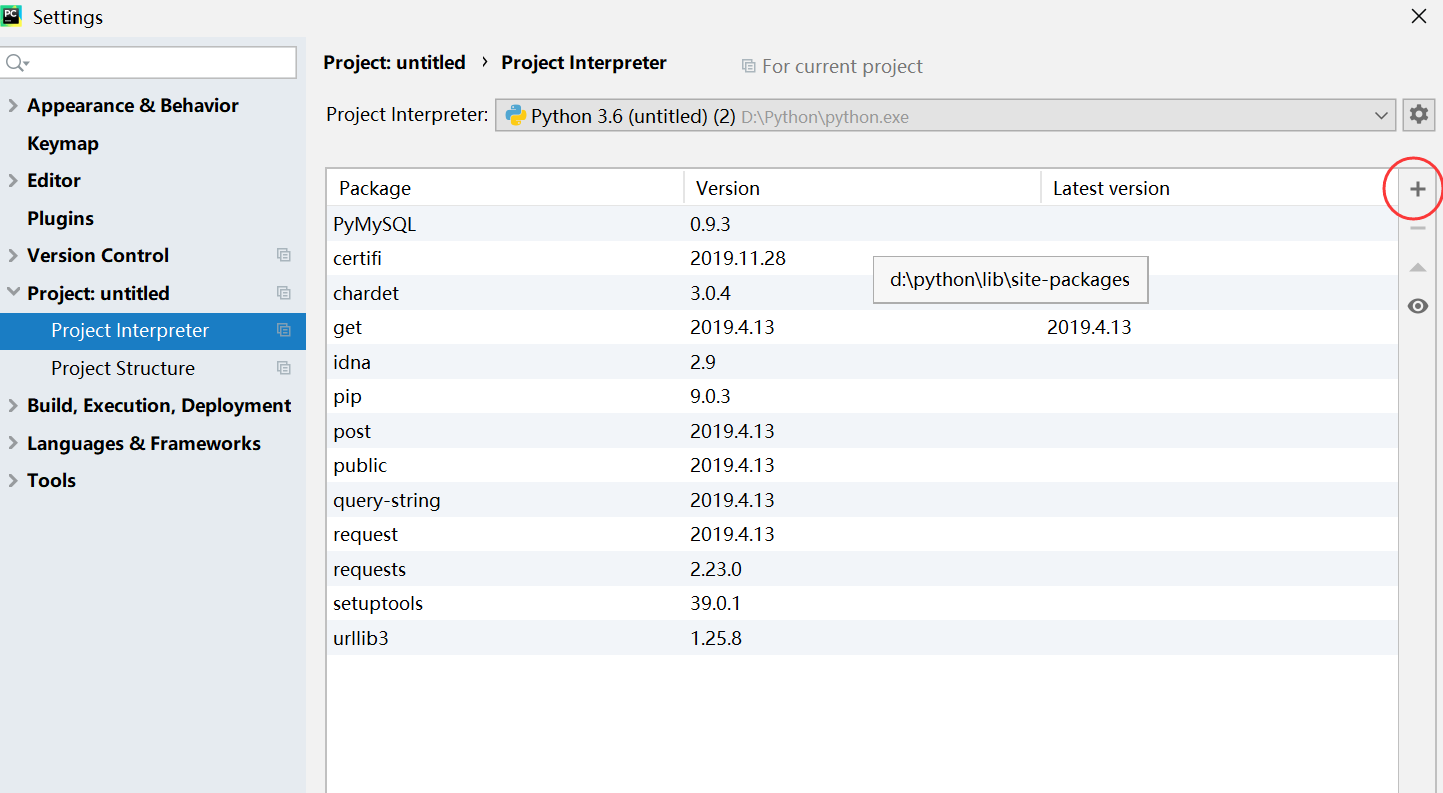

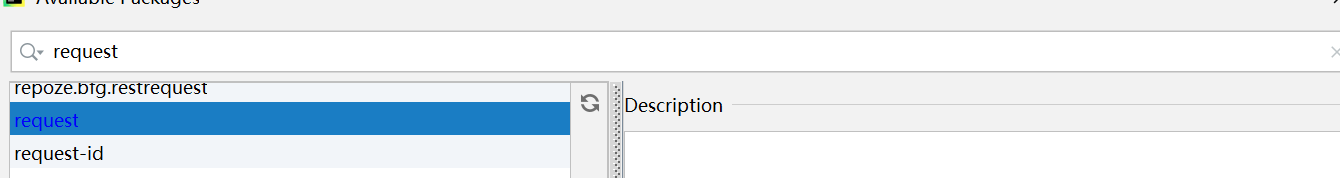

周三的上午PHP结束后就开始了学习python的数据库;刚开始的时候走了岔路,以为数据库还要安装一些其他的软件,然后那些个网站有的不能打开,下载的速度极慢,后来在网上找到了一个数据库的教程,用requests库只需要导进一些东西就可以使用;

还是在老位置如下图:在里面查找你所需要的东西;然后![]() ,这就结束了;

,这就结束了;

这主要是学习了数据库的连接

1 # pip3 install pymysql 2 import pymysql 3 4 conn = pymysql.connect( 5 host='localhost', # 我的IP地址 6 port=3306, # 不是字符串不需要加引号。 7 user='root', 8 password='123456', 9 db='python',#数据库名字 10 charset='utf8' 11 ) 12 13 cursor = conn.cursor() # 获取一个光标 14 sql = 'insert into userinfo (id,user,pwd) values (%s,%s,%s);'#userinfo是表名 15 id = '4' 16 name = 'wuli12' 17 pwd = '1234567895' 18 cursor.execute(sql, [id , name, pwd]) 19 conn.commit()#一个commit表示这一个SQL语句执行的结束 20 21 # 定义将要执行的SQL语句 22 sql = "delete from userinfo where user=%s;" 23 name = "wuli1" 24 # 拼接并执行SQL语句 25 cursor.execute(sql, [name]) 26 # 涉及写操作注意要提交 27 conn.commit() 28 29 30 cursor.close() 31 conn.close()

在python里面要有一个主键;

关于网上的爬虫,差不多都是一个格式参考下方

1 def get_wangyi_request(): 2 url = 'https://c.m.163.com/ug/api/wuhan/app/data/list-total' 3 4 headers = { 5 'accept': '*/*', 6 'accept-encoding': 'gzip,deflate,br', 7 'accept-language': 'en-US,en;q=0.9,zh-CN;q = 0.8,zh;q = 0.7', 8 'origin': 'https://wp.m.163.com', 9 'referer': 'https://wp.m.163.com/', 10 'sec-fetch-dest': 'empty', 11 'sec-fetch-mode': 'cors', 12 'sec-fetch-site': 'same-ite', 13 'user-agent': 'Mozilla/5.0(WindowsNT10.0;Win64;x64) AppleWebKit/37.36 (KHTML, likeGecko) Chrome/82.0.4056.0 Safari/537.36 Edg/82.0.432.3' 14 } 15 16 result = requests.get(url, headers=headers) 17 return result