概述

伪分布式模式下,hadoop将所有进程运行于同一台主机上,但此时hadoop将使用分布式文件系统,而且各jobs也是由JobTracker服务管理的独立进程。同时,由于伪分布式的hadoop集群只有一个节点,因此HDFS的块复制将限制为单个副本,器master和slave也都将运行于本地主机。此种模式除了并非真正意义的分布式以外,其程序执行逻辑完全类似于完成分布式,因此,常用于开发人员测试程序执行。

1.启动HDFS并运行MapReduce程序

1.1 配置hadoop-env.sh文件

vim hadoop/etc/hadoop/hadoop-env.sh

修改内容如下:

# The java implementation to use.

export JAVA_HOME=/usr/lib/jvm/java-1.8.0-openjdk-1.8.0.242.b08-0.el7_7.x86_64

1.2 配置core-site.xml文件

<configuration>

<!--NameNode的IP地址和端口-->

<property>

<name>fs.defaultFS</name>

<value>hdfs://192.168.138.55:9000</value>

</property>

<!--指定hadoop运行时产生文件的存储目录-->

<property>

<name>hadoop.tmp.dir</name>

<value>/opt/module/hadoop/data/temp</value>

</property>

</configuration>

1.3 配置hdfs-site.xml文件

<configuration>

<!--指定HDFS副本的数量-->

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

</configuration>

1.4 启动集群

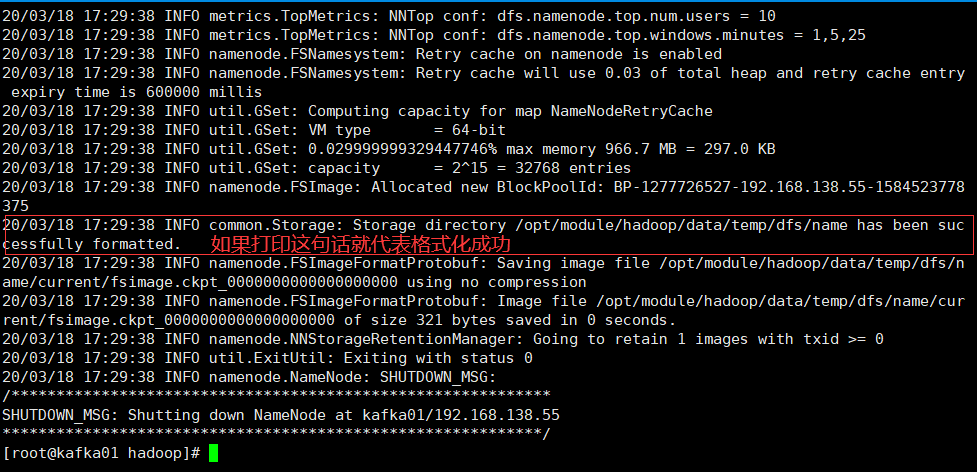

1.4.1 格式化NameNode(第一次启动时格式化,以后就不要总格式化)

bin/hdfs namenode -format

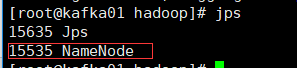

1.4.2 启动NameNode

hadoop-daemon.sh start namenode

![]()

可以使用【jps】命令查看是否成功启动namenode

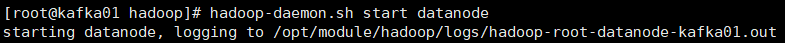

1.4.3 启动DataNode

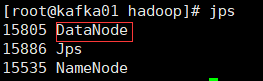

hadoop-daemon.sh start datanode

使用【jps】命令查看是否成功启动DataNode

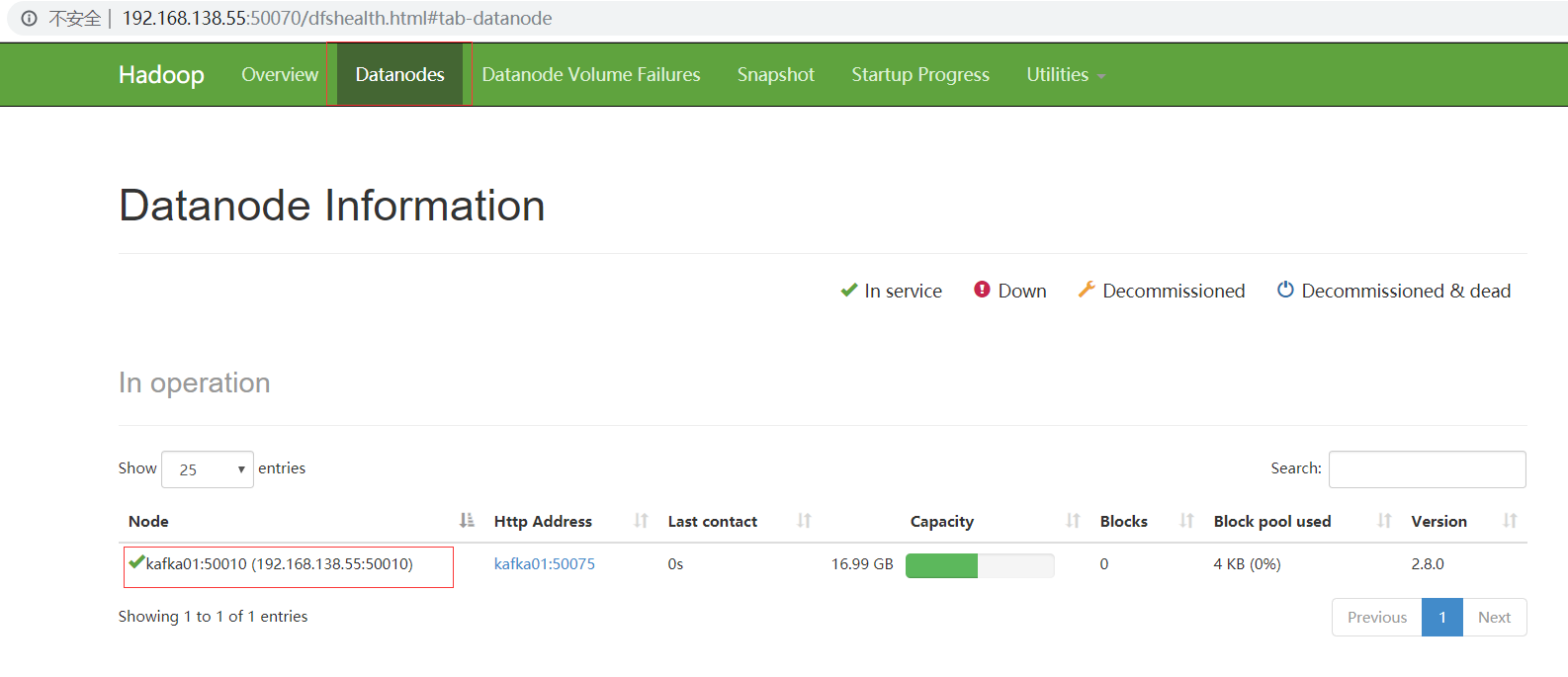

1.5 访问网页

地址:http://192.168.138.55:50070/

1.6 为什么不能一直格式化namenode,格式化NameNode,需要注意什么?

格式NameNode,会产生新的集群id,导致NameNode和DataNode的集群id不一致,集群找不到以往的数据。所以,格式NameNode时,一定要先删除data数据和log日志,然后在格式化NameNode

2.启动yarn并运行MapReduce程序

2.1 配置yarn-env.sh文件

# some Java parameters

export JAVA_HOME=/usr/lib/jvm/java-1.8.0-openjdk-1.8.0.242.b08-0.el7_7.x86_64

2.2 配置yarn-site.xml文件

<configuration>

<!-- Site specific YARN configuration properties -->

<!-- Reducer获取数据的方式 -->

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<!-- 指定YARN的ResourceManager的地址 -->

<property>

<name>yarn.resourcemanager.hostname</name>

<value>192.168.138.55</value>

</property>

</configuration>

2.3 配置mapred-env.sh文件

export JAVA_HOME=/usr/lib/jvm/java-1.8.0-openjdk-1.8.0.242.b08-0.el7_7.x86_64

2.4 配置mapred-site.xml文件

2.4.1 将mapred.site.xml.template文件改为mapred-site.xml文件

cp mapred-site.xml.template mapred-site.xml

2.4.2 配置文件内容如下:

<configuration>

<!-- 指定MR运行在YARN上 -->

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

</configuration>

2.5启动集群

2.5.1 启动前必须保证NameNode和DataNode已经启动;

2.5.2 启动ResourceManager

yarn-daemon.sh start resourcemanager

2.5.6 启动NodeManager

yarn-daemon.sh start nodemanager

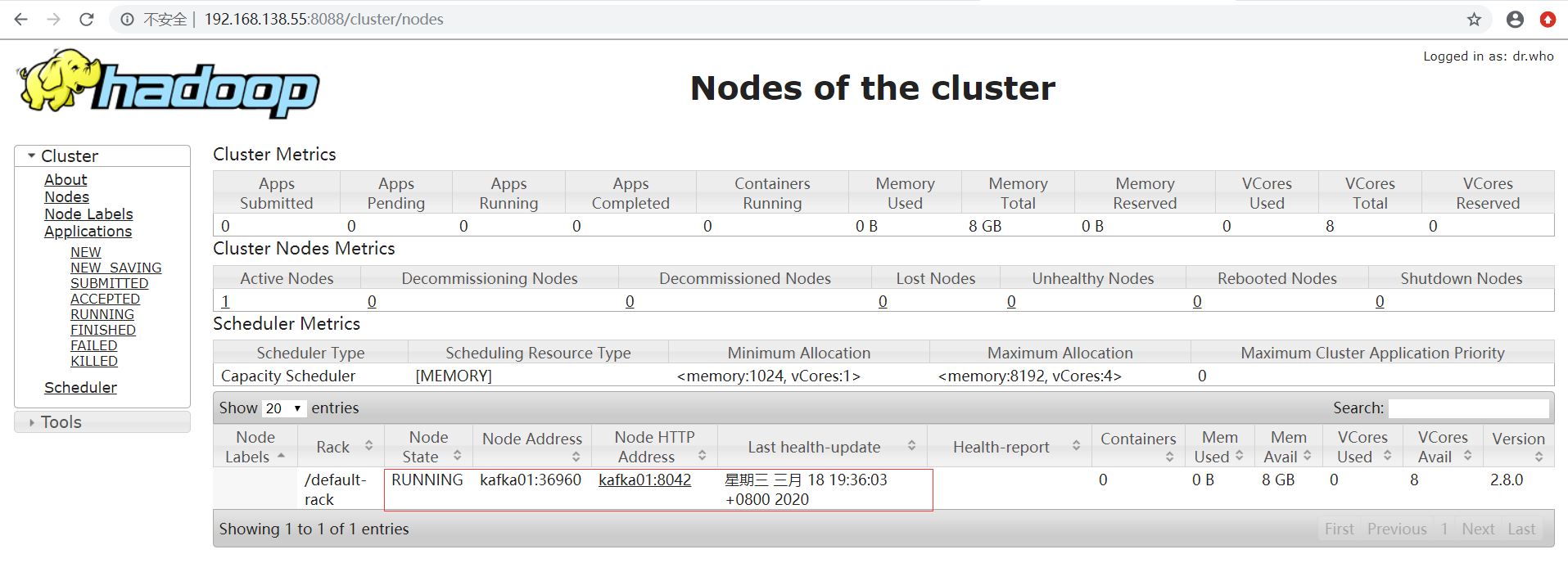

2.6 访问网页

地址:http://192.168.138.55:8088/cluster

2.7 集群操作

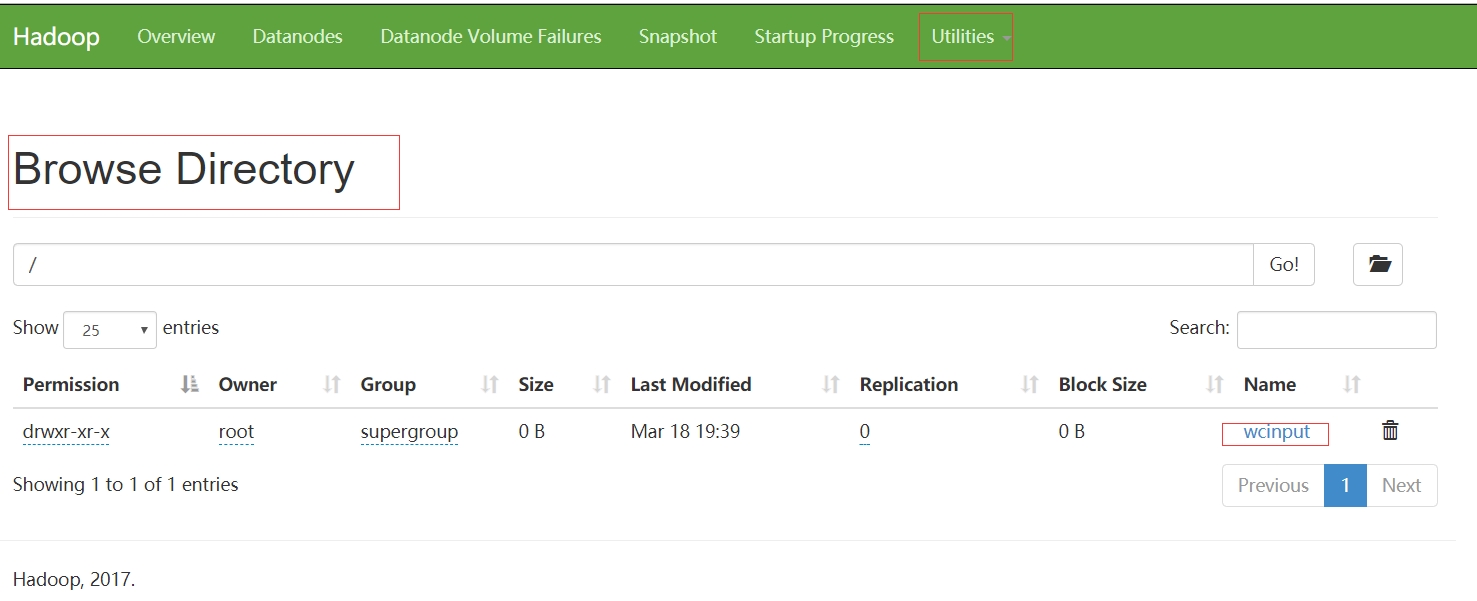

2.7.1 上传wcinput文件夹到HDFS上

hadoop fs -put wcinput /

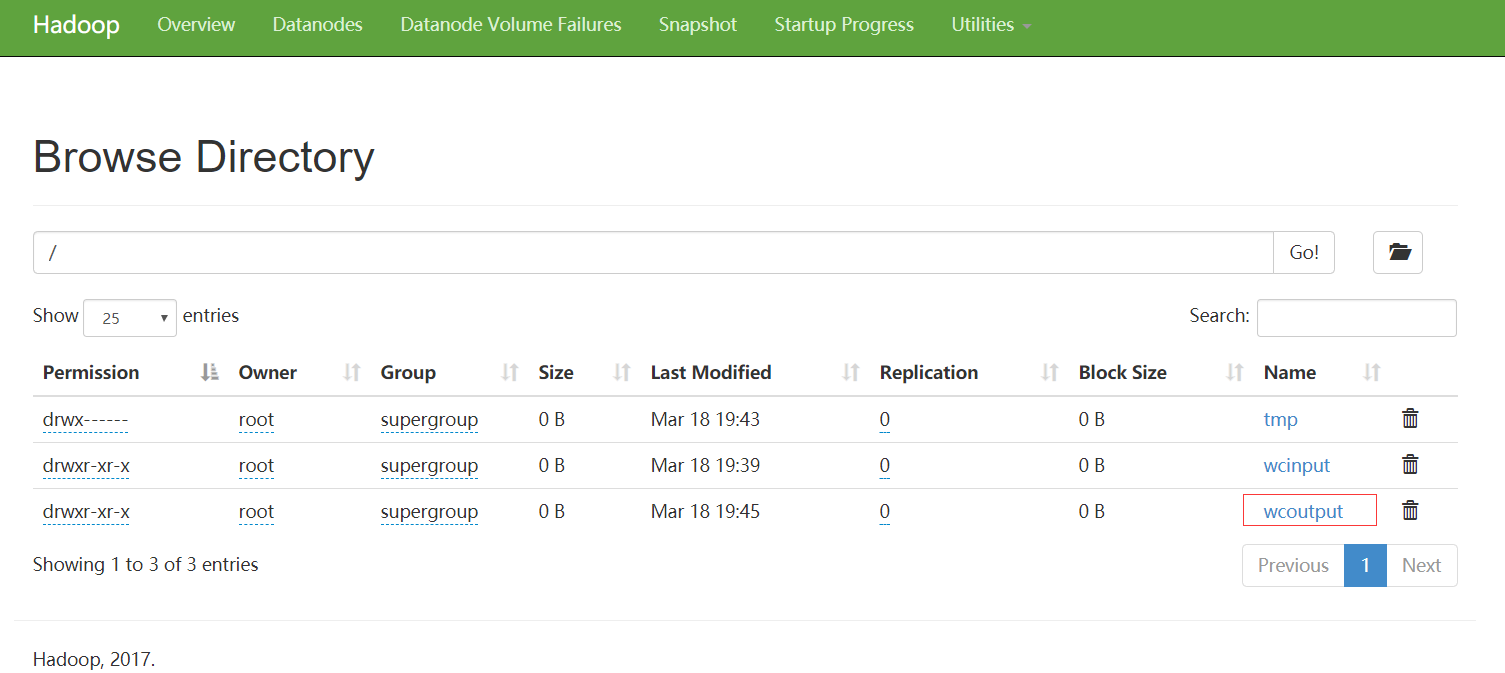

2.7.2 执行MapReduce程序

hadoop jar share/hadoop/mapreduce/hadoop-mapreduce-examples-2.8.0.jar wordcount /wcinput /wcoutput

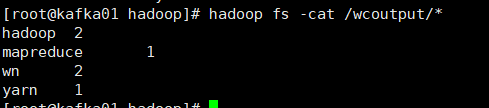

2.7.3 查看运行结果

hadoop fs -cat /wcoutput/*

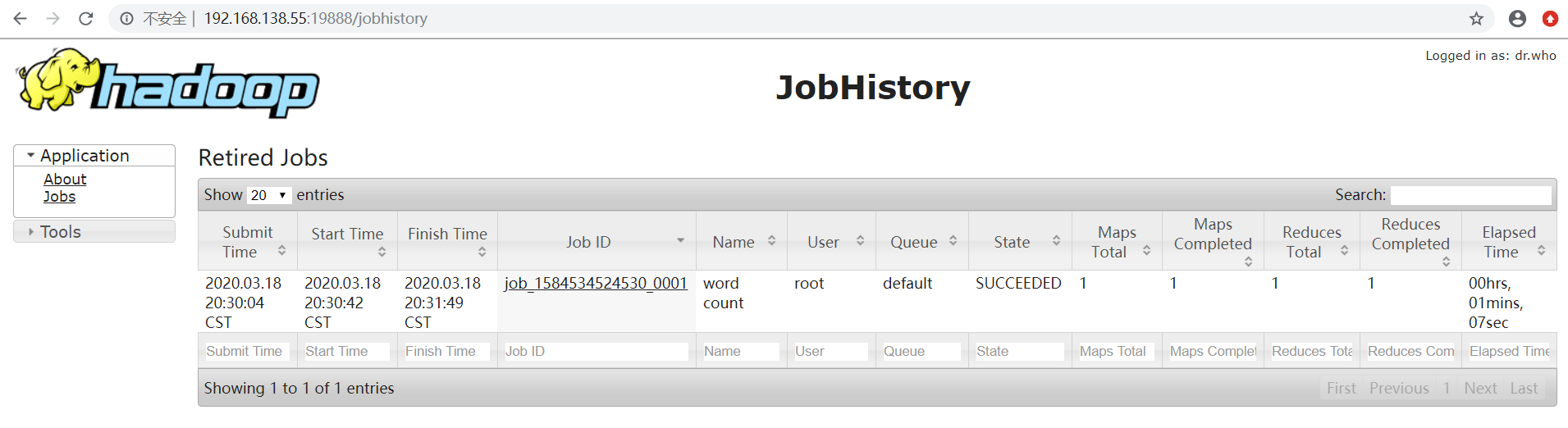

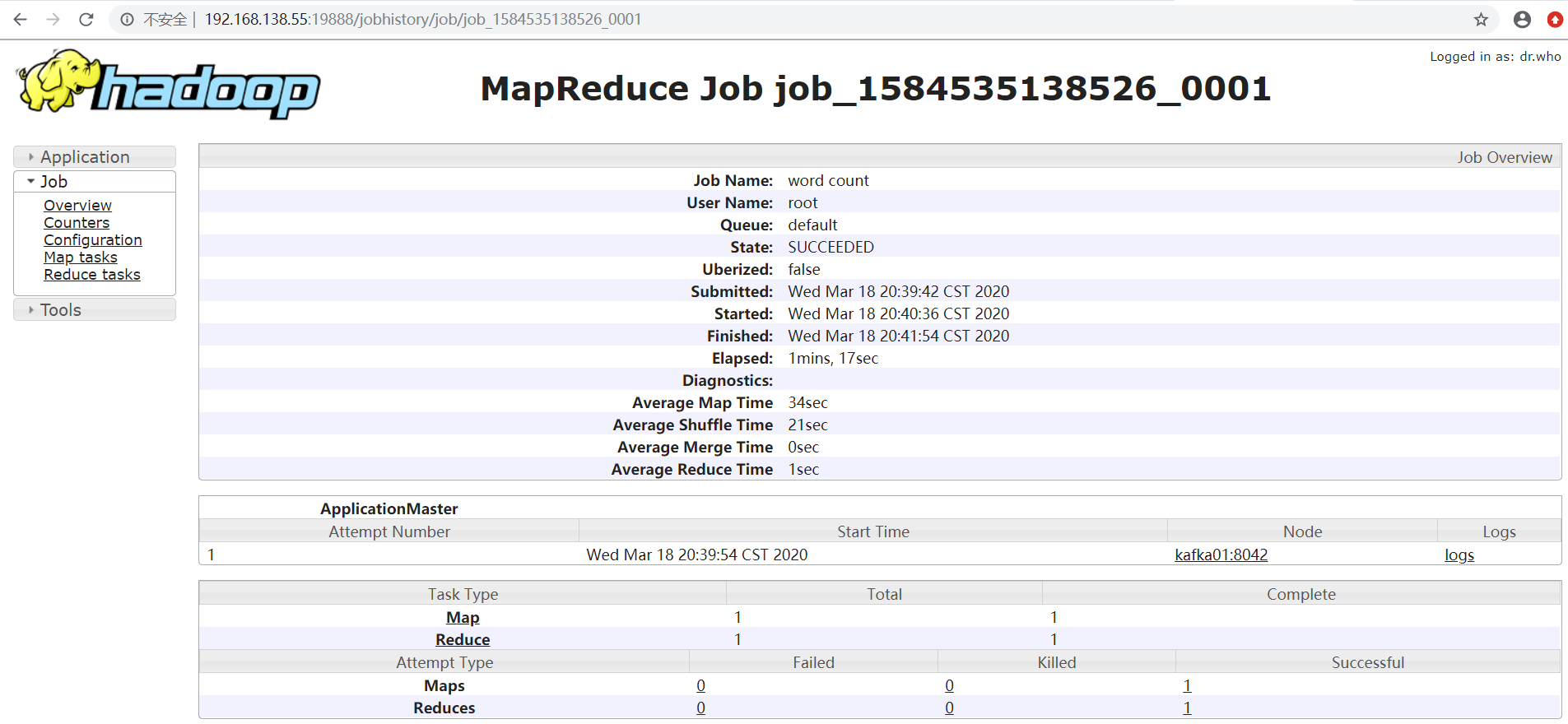

3.配置历史服务器

为了查看程序的历史运行情况,需要配置一个历史服务器;

3.1 配置mapred-site.xml

<!-- 历史服务器端地址 -->

<property>

<name>mapreduce.jobhistory.address</name>

<value>192.168.138.55:10020</value>

</property>

<!-- 历史服务器web端地址 -->

<property>

<name>mapreduce.jobhistory.webapp.address</name>

<value>192.168.138.55:19888</value>

</property>

3.2 启动历史服务器

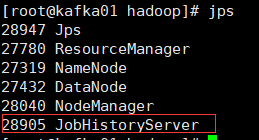

sbin/mr-jobhistory-daemon.sh start historyserver

3.3 使用【jps】查看历史服务器是否启动

3.4 查看JobHistory

地址:http://192.168.138.55:19888

4.配置日志的聚集

日志聚集概念:应用运行完成之后,将程序运行日志信息上传到HDFS系统上;

日志聚集功能好处:可以方便的查看到程序运行情况,方便开发调试;

注意:开启日志聚集功能,需要启动NodeManager,ResourceManager和HistoryManager;

4.1 配置yarn-site.xml文件

<!-- 日志聚集功能使能 -->

<property>

<name>yarn.log-aggregation-enable</name>

<value>true</value>

</property>

<!-- 日志保留时间设置7天 -->

<property>

<name>yarn.log-aggregation.retain-seconds</name>

<value>604800</value>

</property>

4.2 关闭NodeManager,ResourceManager和HistoryManager

sbin/yarn-daemon.sh stop resourcemanager

sbin/yarn-daemon.sh stop nodemanager

sbin/mr-jobhistory-daemon.sh stop historyserver

4.3 启动NodeManager,ResourceManager和HistoryManager

sbin/yarn-daemon.sh start resourcemanager

sbin/yarn-daemon.sh start nodemanager

sbin/mr-jobhistory-daemon.sh start historyserver

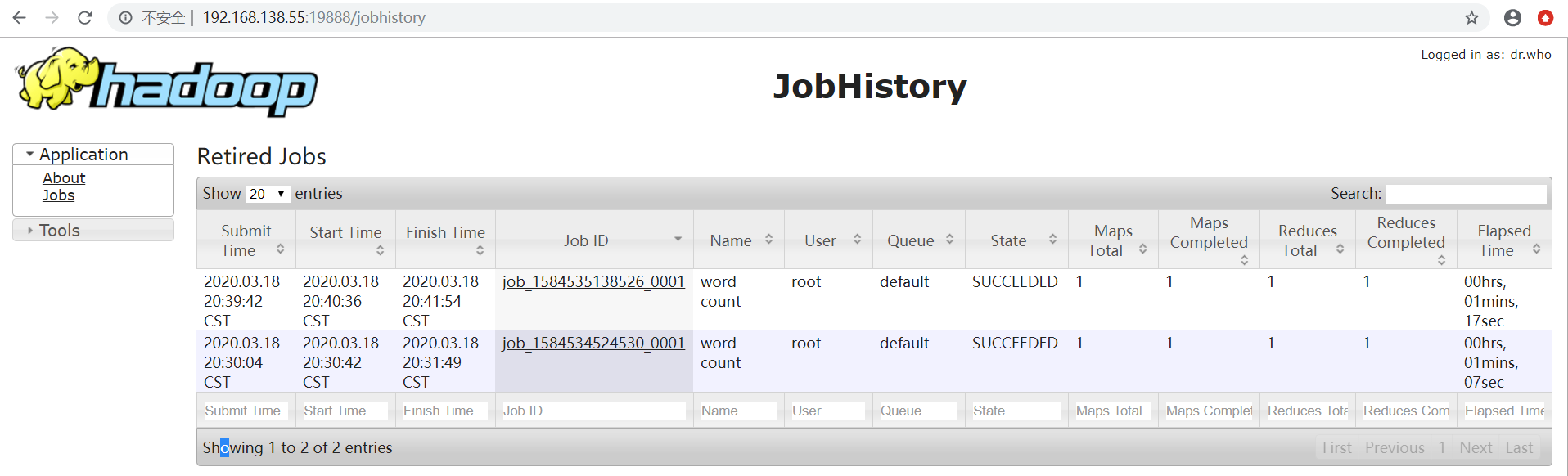

4.4 删除HDFS上已经存在的输出文件

bin/hdfs dfs -rm -R /wcoutput

4.5 执行WordCount程序

hadoop jar share/hadoop/mapreduce/hadoop-mapreduce-examples-2.8.0.jar wordcount /wcinput /wcoutput

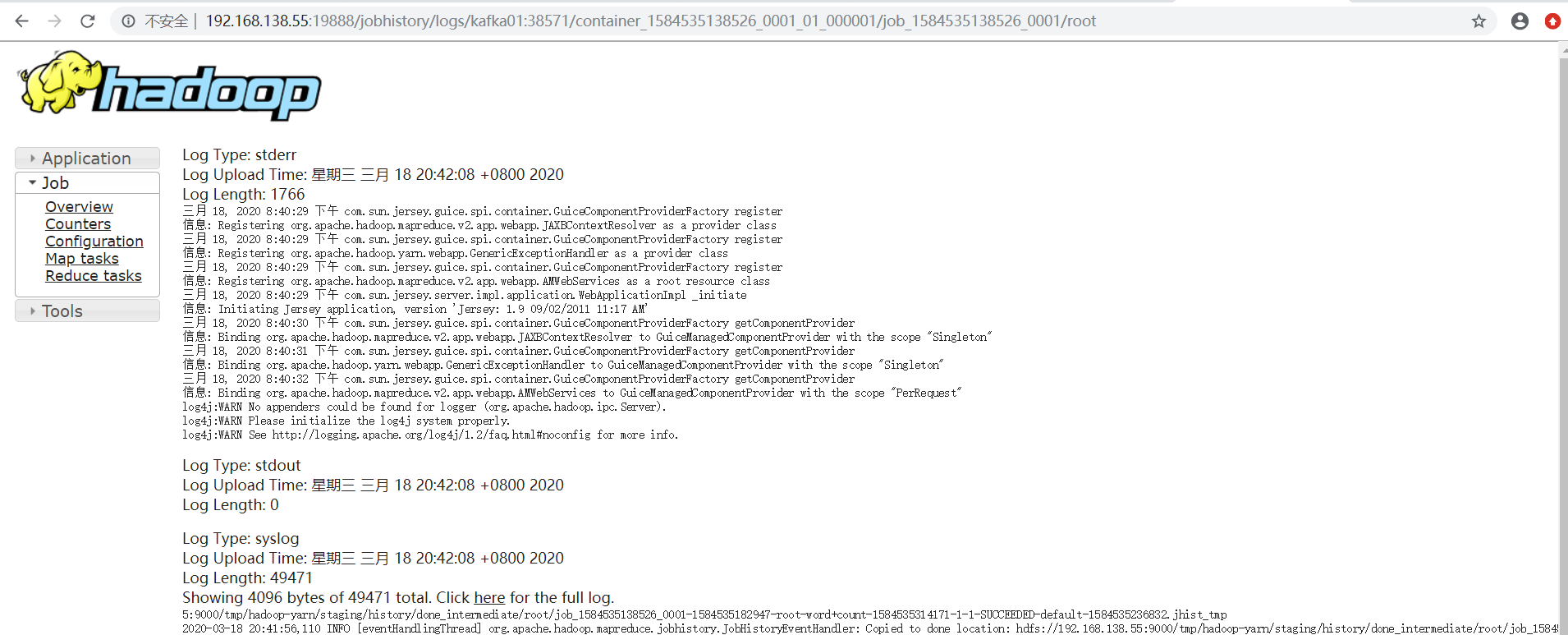

4.6 查看日志

地址:http://192.168.138.55:19888

点击logs即可查看日志

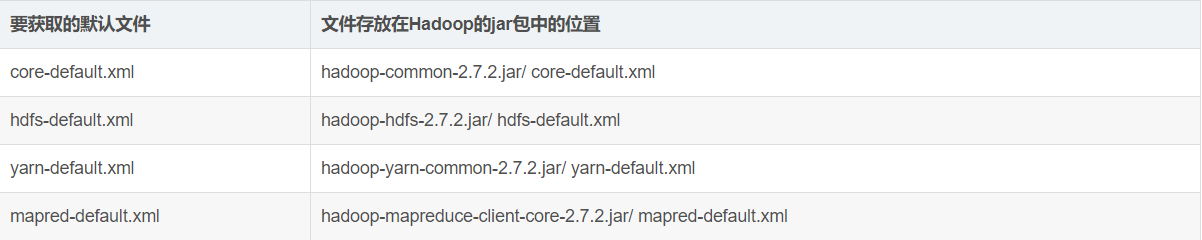

5.配置文件说明

hadoop配置文件分两类:默认胚子文件个自定义配置文件,只有用户像修改某一默认配置值时,才需要修改自定义配置文件,更改响应属性值;

5.1 默认配置文件

5.2 自定义配置文件

core-site.xml,hdfs-site.xml,yarn-site.xml,mapred-site.xml四个配置文件存放在/etc/hadoop这个路径上,用户可以根据项目需求进行修改配置;