呃 其实要明天上午才能知道是否成功,毕竟改了一个小参数的。

首先,来学两个小命令:

1 step1: 2 $ sudo crontab -e 3 4 step2: 5 # 然后提示password输入密码,即可进入编辑页面 6 7 step3: 8 # 按下i键,进入编辑模式 9 10 step4: 11 * * * * * 绝对路径/bin/pytho3.5 绝对文件路径/a.py 12 # 其中,五个星号分别代表 分(0~59)、时(0~23)、天(1~31)、月(1~12)、星期(0~7) 13 14 step5: 15 # 按下esc还是什么键,我反正乱按的,退出编辑模式,然后按:wq,表示保存后退出,如果按:q就是直接退出不保存的意思; 16 17 step6: 18 $ sudo crontab -l 19 # 查看定时计划内容

注意事项:

1. mac中默认执行python的是python2.7,所以必须写出python3.5的绝对路径(bin下);

2.要执行的文件不可以放在中文、空格等路径下;

3.第五颗* 表示星期,取值范文0~7,其中0和7都表示星期日,工作日的表示方法是1-5,或者1,2,3,4,5

4.如果* 就表示全部的取值范围

用crontab 实现 scrapy

step1. 先进入scrapy的工程路径;

step2.再从scrapy的bin下执行scapy命令;

以上,用cd 的那个真的是个坑,根本无法实现,大家别费力气啦,改用sh吧,注意事项如下:

step1:写sh文件,将以上的内容写入wangyi.sh 文件;

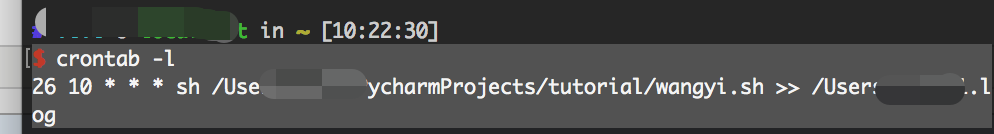

step2:在crontab中,写命令 要 sh wangyi.sh,绝对路径, 输出log文件;

遗留问题:我的log ,只是创建了log文件,并没任何内容写入,好奇怪,不会搞;

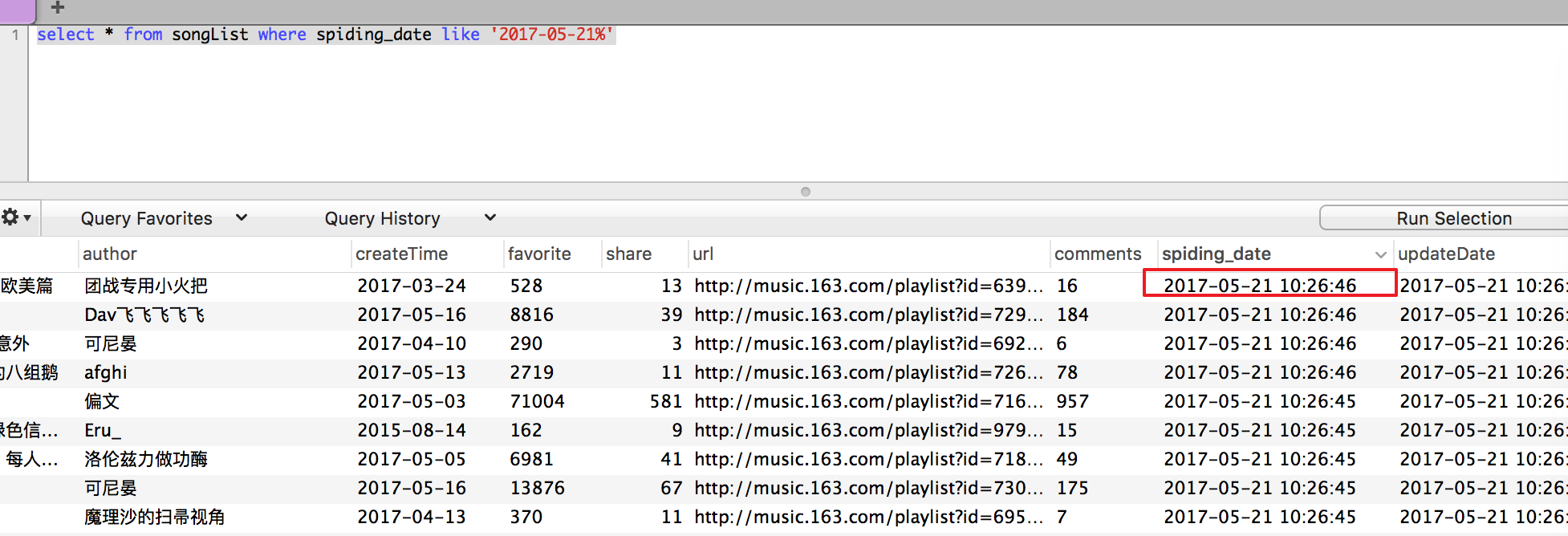

贴一下成果图: