转自:https://www.cnblogs.com/zhangshenghui/p/11718486.html

1.Linux 总线模型

Linux下的任何驱动在内核中最终都抽象为bus, driver以及device三者间的相互作用。

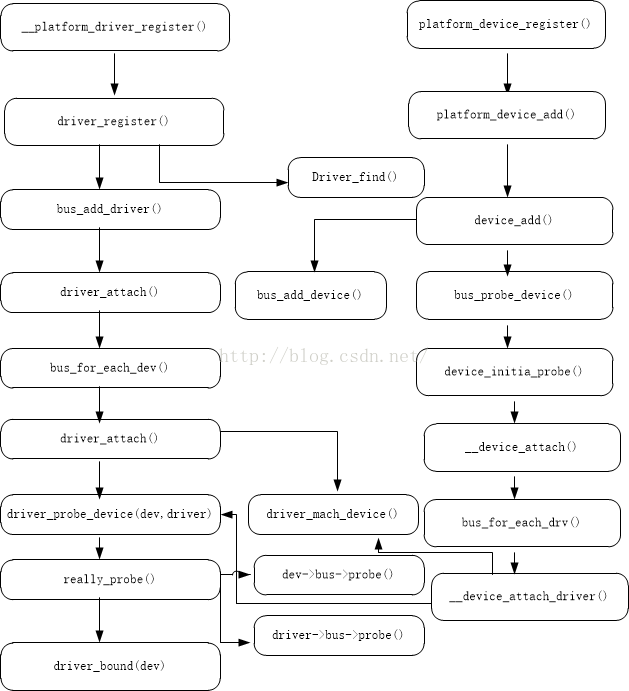

总线是处理器和一个或多个设备之间的通道,在设备模型中,所有的设备都通过总线相连接。总线将设备和驱动绑定,在系统每注册一个设备的时候,会遍历该总线上的driver list,通过bus的math函数寻找与之匹配的驱动;相反的,在系统每注册一个驱动的时候,会便利该总线上的device 寻找与之匹配的设备,而匹配由总线的match函数完成。一但匹配,则会调用总线的probe函数。

在此模型下,如果存在实际总线当然很好,比如mmc总线,i2c总线和spi总线,相应的device和driver都可以直接注册在总线上。但是总是有一些设备和总线无关,为此,linux kernel引入了platform 虚拟总线,

Platform总线是一种虚拟的总线,相应的设备则为platform_device,通过platform_driver_register;而驱动则为platform_driver,通过platform_driver_register 注册。内核中该总线定义如下:

struct bus_type platform_bus_type = {

.name = "platform",

.dev_groups= platform_dev_groups,

.match = platform_match,

.uevent = platform_uevent,

.pm = &platform_dev_pm_ops,

};

platform_总线match采用名称匹 配的方式,即driver和device两者的name一样则认为该device对应该driver,详见下图:

2.MMC 简介

MMC

MMC全称MultiMedia Card,由西门子公司和SanDisk公司1997年推出的多媒体记忆卡标准。MMC卡尺寸为32mm x24mm x 1.4mm,它将存贮单元和控制器一同做到了卡上,智能的控制器使得MMC保证兼容性和灵活性。

MMC卡具有MMC和SPI两种工作模式,MMC模式是默认工作模式,具有MMC的全部特性。而SPI模式则是MMC协议的一个子集,主要用于低速系统。

SD

SD卡全称Secure DigitalMemory Card,由松下、东芝和SanDisk公司于1999年8月共同开发的新一代记忆卡标准,已完全兼容MMC标准。SD卡比MMC卡多了一个进行数据著作权保护的暗号认证功能。

SD卡尺寸为32mm x 24mm x2.1mm,长宽和MMC卡一样,只是比MMC卡厚了0.7mm,以容纳更大容量的存贮单元。SD卡与MMC卡保持向上兼容,也就是说,MMC卡可以被新的设有SD卡插槽的设备存取,但是SD卡却不可以被设有MMC插槽的设备存取。

SDIO

SDIO全称Secure DigitalInput and Output Card,SDIO是在SD标准上定义了一种外设接口,它使用SD的I/O接口来连接外围设备,并通过SD上的I/O数据接口与这些外围设备传输数据。现在已经有很多手持设备支持SDIO功能,而且许多SDIO外设也被开发出来,目前常见的SDIO外设有:WIFI Card、GPS Card、 Bluetooth Card等等。

eMMC

eMMC全称Embedded MultiMediaCard,是MMC协会所制定的内嵌式存储器标准规格,主要应用于智能手机和移动嵌入式产品等。eMMC是一种嵌入式非易失性存储系统,由闪存和闪存控制器两部分组成,它的一个明显优势是在封装中集成了一个闪存控制器,它采用JEDEC标准BGA封装,并采用统一闪存接口管理闪存。

eMMC结构由一个嵌入式存储解决方案组成,带有MMC接口、快闪存储设备及主控制器,所有这些由一个小型BGA封装。由于采用标准封装,eMMC也很容易升级,并不用改变硬件结构。

eMMC的这种将Nand Flash芯片和控制芯片封装在一起的设计概念,就是为了简化产品内存储器的使用,客户只需要采购eMMC芯片放进产品中,不需要处理其它复杂的Nand Flash兼容性和管理问题,减少研发成本和研发周期。

3.MMC 模块总线模型

mmc子系统涉及到三条总线,如下:

Host驱动相应的driver和device挂载在Linux内核内置的虚拟抽象总线platform_bus_type。两者的匹配采用名称匹配的方式,即driver和device两者的name一样则认为该device对应该driver,这里是”rda,hsmmc”。

Card驱动相应的driver和device挂载在mmc自己创建的虚拟总线mmc_bus_type下,直接匹配。

Sdio驱动相应的driver和device挂载在mmc自己创建的虚拟总线sdio_bus_type下,ID匹配。

按照时间先后顺序,mmc模块中bus,device和driver的注册顺序如下:

3.1.host device

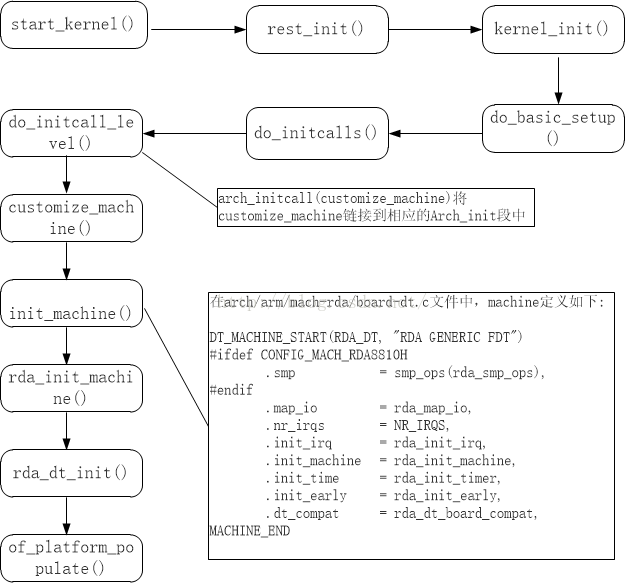

linux kernel 通过下图所示流程,解析dts文件mmc模块相关配置,生成名为rda,hsmmc的platformdevice,挂在platform平台总线上。

3.2.mmc_bus, sdio_bus

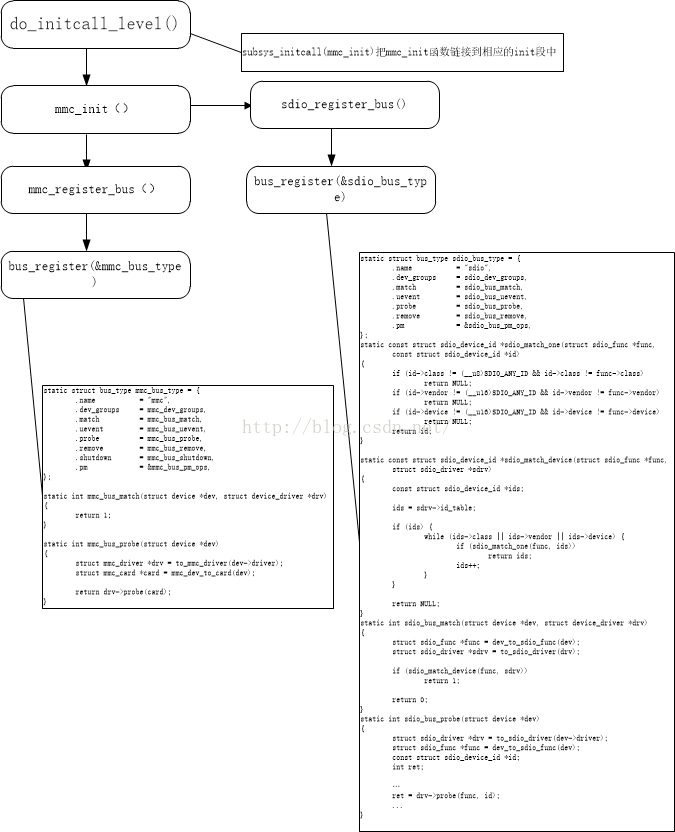

mmc core初始化时,文件core.c中的subsys_initcall(mmc_init), 调用mmc_register_bus和sdio_register_bus注册mmc bus 和sdio bus,具体如图下图所示。

由上图可以看出,任何挂在mmc总线上的device 和driver都会匹配,而挂在sdio总线上的设备和deriver需要通过id进行匹配。

3.3.card driver

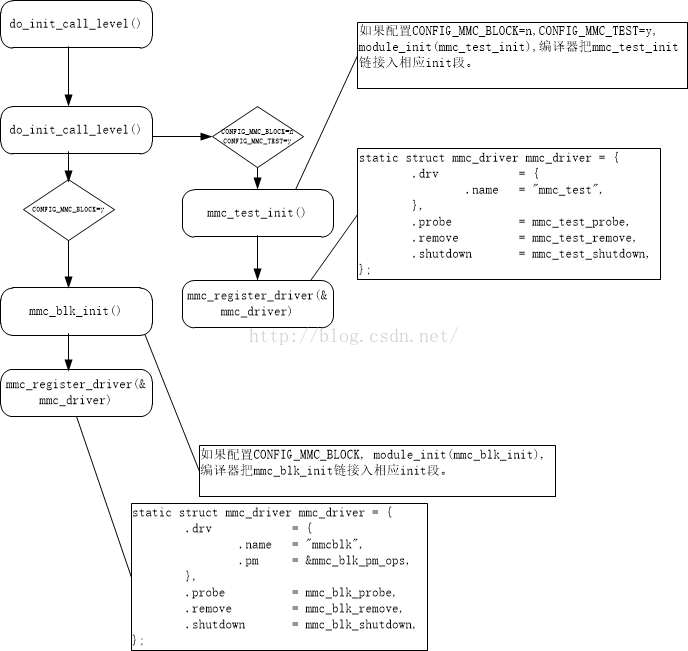

card目录下,block.c中module_init(mmc_blk_init)调用mmc_register_driver函数创建mmcblk driver,并将之挂载到mmc_bus_type总线的driver list链表上。

注意:mmc core提供了mmc_test.c作为mmc driver的测试文件。mmc_test.c中,module_init(mmc_test_init)函数中,调用mmc_register_driver函数创建了mmc_test driver,并且将之挂载在mmc_bus_type总线的driver list链表上。

mmc模块如果需要使用mmc_test功能,需要把CONFIG_MMC_BLOKC宏关闭,然后把CONFIG_MMC_BLOCK=y。否则,card将会匹配blockdreiver,不会再次匹配mmc_test driver,具体见下图。

3.4.host driver

host目录下,rda_sgmmc.c文件中,module_init(rda_mmc_init),把rda_mmc_init链接到相应的init字段中。在初始化时候,执行rda_mmc_init(),调用platform_driver_register注册名为rda,hsmmc的host

driver,此driver挂在platform虚拟总线上。

3.5. card device

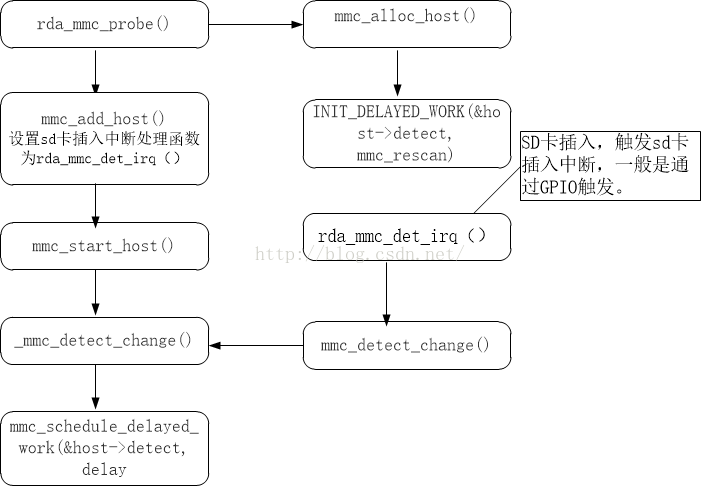

在第四步中,hostdriver注册成功后,platform总线会把此driver和1中注册的host

dev匹配,然后执行host driver的probe 函数rda_mmc_probe。该函数中完成mmc_alloc_host申请mmc

host 结构体,然后完成初始化,以及中断等的申请等,最后调用mmc_add_host完成card 的探测,如果card存在,生成card

device。

因为sd卡支持热插拔,所以在probe阶段,sd卡没有插入的情况下,不会生成card device。而是在后期插入sd卡时候,产生中断,中断处理函数中调用mmc_detect_change函数探测sd card是否存在,完成初始化并且生成card device。具体见下图。

从上图中,我们并没有看到card设备的生成。这是因为我们通过detect work完成了sd,mmc,或sdio设备的初始化,并且生成相应的block设备,具体见下图:

3.6. card driver执行

在第五步中,card device已经挂到mmc总线上,此时会匹配到carddriver,自动执行driver

的probe函数。如果在3中,CONFIG_MMC_BLOCK=y,则会执行mmc_blk_probe,生成block设备。如果CONFIG_MMC_BLOCK=n,

CONFIG_MMC_TEST=y,则会自动执行mmc_test_probe。

综上所述,设备通过dts文件把mmc host dev(platform设备)挂在虚拟平台总线上,然后注册sdio和mmc总线,紧接着注册card driver,挂在mmc总线上。其后,在host目录下,我们自己的driver中,调用platform_driver_register注册platform平台驱动,即host driver。此时,platform会匹配host dev 和driver,执行driver的probe函数,通过mmc_add_host注册card

device,挂载到mmc总线上。最后,mmc总线会匹配card dev 和driver,执行card driver的probe函数,生成block设备或者mmc_test相关的属性文件。

4.MMC 协议实现

到此为止,mmc 的相关框架已经介绍清楚了。因为在框架明了的情况下,驱动已经很简单了,所以后面仅仅会简单介绍一下mmc驱动。

sd,sdio或者mmc的协议实现在哪里呢?可以在图5中看到,初始化就是在mmc_attach_sdio, mmc_attach_sd或者mmc_attach_mmc函数中。

1.初始化时候,首先发送cmd0使卡进入idle状态;

2.接着发送cmd8,检测卡是否SD2.0。SD1.1不支持cmd8,因此如果发送cmd8无回应,则卡为SD1.1,否则就是SD2.0;

3. mmc_attach_sdio发送cmd5读取OCR 寄存器,判断是否为sdio,如果是就绑定sdio总线;

4. mmc_attach_sd发送命令acmd55、cmd41,使卡进入工作状态。如果通过,则认为是sd卡,绑定sd总线。mmc卡不支持acmd55,和cmd41,所以如果无回应,则认为卡是mmc卡;

5. mmc_attach_mmc中发送命令1,判断是否为mmc卡,如果回应,则绑定mmc总线。如果cmd1无回应,则不是mmc卡。

具体实现和协议强相关,只要对照协议来看,很简单,就不再多述了。

ls kernel/drivers/mmc,可以看到如下三个目录:

card core host

card目录下主要是完成了上章中所述的mmc总线driver,也就是2.3所述的card driver,

core目录主要是完成了上章中sdio bus和mmc bus注册,card device的添加,host目录就是具体的host driver的添加了。

在mmc driver中,需要做的很重要的一部就是实现mmc_host_ops,在probe函数中把其赋值给mmc_host 结构体的ops变量,rda_sgmmc.c的mmc_host_ops实现如下:

static const struct mmc_host_ops rda_mmc_ops= {

.request = rda_mmc_request,

.get_ro = rda_mmc_get_ro,

.get_cd = rda_mmc_get_cd,

.set_ios = rda_mmc_set_ios,

.enable_sdio_irq =rda_mmc_enable_sdio_irq,

};

其中,request函数,主要实现命令发送,数据的读写;set_ios主要用来设置数据速度,mmc相位,power mode 和data bus width;get_cd用来检测设备是否存在;get_ro用来判断mmc是否为read-only card;enable_sdio_irq是用来使能或者关闭sdio中断。

mmc dev正常读写的时候调用流程是怎么样呢?怎么和上面注册的mmc_host_ops关联起来呢?块设备的读写会被放入request_queue。见下图:

其中,blk_fetch_request等涉及到block文件的读写实现方式,这里不再叙述,有兴趣的话大家可以看看代码。

由此,mmc card dev就和上面注册的mmc_host_ops关联起来了。

5.MMC test driver 使用

在第二章介绍card driver时候已经介绍到了mmc test driver了。如果要使用mmc_test function,可以按照如下步骤:

1.CONFIG_MMC_BLOCK=n,CONFIG_MMC_TEST=y。或者CONFIG_MMC_BLOCK=y, CONFIG_MMC_TEST=y。如果选用后一种配置,需要再系统起来后,在总线driver中手动bind和unbind,见后面;

2.CONFIG_DEBUG_FS=y,CONFIG_DEBUG_KERNEL=y,这两项在我们项目的kernel的defconfig中已经配置,所以不需要进行改动;

3. mount -t debugfs none /sys/kernel/debug,这个我们的project中已经挂载了,不需要进行改动;

完成上面三项后,启动系统,如果在步骤1中CONFIG_MMC_BLOCK=y,那么需要先执行执行如下操作:

etau:/ # ls sys/bus/mmc/devices/

mmc0:aaaa

etau:/sys/bus/mmc/drivers # ls

mmc_test/ mmcblk/

etau:/sys/bus/mmc/drivers # cd mmcblk/

etau:/sys/bus/mmc/drivers/mmcblk # ls -al

total 0

drwxr-xr-x 2 root root 0 2000-01-01 01:27 .

drwxr-xr-x 4 root root 0 2000-01-01 01:27 ..

--w------- 1 root root 4096 2000-01-01 01:28bind

lrwxrwxrwx 1 root root 0 2000-01-01 01:28 mmc0:aaaa ->../../../../devices/soc0/20a50000.rda-mmc0/mmc_host/mmc0/mmc0:aaaa

--w------- 1 root root 4096 2000-01-01 01:28uevent

--w------- 1 root root 4096 2000-01-01 01:28unbind

etau:/sys/bus/mmc/drivers/mmcblk #echo –n mmc0:aaaa> unbind

etau:/sys/bus/mmc/drivers # cdmmc_test/

etau:/sys/bus/mmc/drivers/mmc_test # ls

bind uevent unbind

etau:/sys/bus/mmc/drivers/mmc_test #echo –n mmc0:aaaa> bind

完成上述操作后,完成了mmc0:aaaa和mmc_test driver的绑定。后续步骤完全一致,如下:

etau:/sys/kernel/debug/mmc0/mmc0:aaaa# cat testlist

1: Basic write (no data verification)

2: Basic read (no data verification)

3: Basic write (with data verification)

4: Basic read (with data verification)

5: Multi-block write

6: Multi-block read

7: Power of two block writes

8: Power of two block reads

9: Weird sized block writes

10: Weird sized block reads

11: Badly aligned write

12: Badly aligned read

13: Badly aligned multi-block write

14: Badly aligned multi-block read

15: Correct xfer_size at write (start failure)

16: Correct xfer_size at read (start failure)

17: Correct xfer_size at write (midway failure)

18: Correct xfer_size at read (midway failure)

19: Highmem write

20: Highmem read

21: Multi-block highmem write

22: Multi-block highmem read

23: Best-case read performance

24: Best-case write performance

25: Best-case read performance into scattered pages

26: Best-case write performance from scatteredpages

27: Single read performance by transfer size

28: Single write performance by transfer size

29: Single trim performance by transfer size

30: Consecutive read performance by transfer size

31: Consecutive write performance by transfer size

32: Consecutive trim performance by transfer size

33: Random read performance by transfer size

34: Random write performance by transfer size

35: Large sequential read into scattered pages

36: Large sequential write from scattered pages

37: Write performance with blocking req 4k to 4MB

38: Write performance with non-blocking req 4k to 4MB

39: Read performance with blocking req 4k to 4MB

40: Read performance with non-blocking req 4k to 4MB

41: Write performance blocking req 1 to 512 sg elems

42: Write performance non-blocking req 1 to 512 sg elems

43: Read performance blocking req 1 to 512 sg elems

44: Read performance non-blocking req 1 to 512 sg elems

45: Reset test

然后执行etau:/sys/kernel/debug/mmc0/mmc0:aaaa# echo 1 > test可以看到测试结果:

[314034.644348] mmc0: Starting tests of cardmmc0:aaaa...

[314034.645080] mmc0: Test case 1. Basicwrite (no data verification)...

[314034.647583] mmc0: Result: OK

[314034.647827] mmc0: Tests completed.

至此,mmc模块就告一段落了。

————————————————

版权声明:本文为CSDN博主「kivy_xian」的原创文章,遵循 CC 4.0 BY-SA 版权协议,转载请附上原文出处链接及本声明。

原文链接:https://blog.csdn.net/kivy_xian/article/details/53333831