Spark基础

什么是spark

也是一个分布式的并行计算框架

spark是下一代的map-reduce,扩展了mr的数据处理流程。

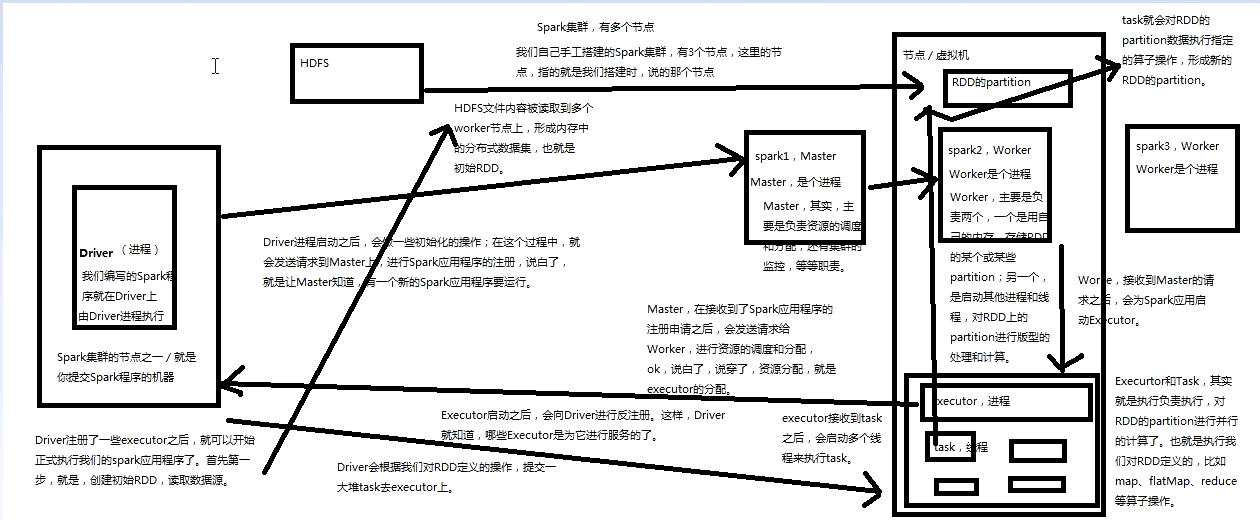

Spark架构原理图解

RDD[Resilient Distributed Dataset]

它是一个弹性分布式数据集,具有良好的通用性、容错性与并行处理数据的能力,为用户屏蔽了底层对数据的复杂抽象和处理,为用户提供了一组方便的数据转换与求值方法。

-

弹性

- 存储弹性:n内存与磁盘d额自动切换

- 容错弹性:数据丢失可以自动恢复

- 计算的弹性:计算出错重试机制

- 分片弹性:根据需要重新分片

-

容错

-

通常在不同机器上备份数据或者记录数据更新的方式完成容错,但这种对任务密集型任务代价很高

-

RDD采用数据应用变换(map,filter,join),若部分数据丢失,RDD拥有足够的信息得知这部分数据是如何计算得到的,可通过重新计算来得到丢失的数据

-

这种恢复数据方法很快,无需大量数据复制操作,可以认为Spark是基于RDD模型的系统

-

-

懒操作

- 延迟计算,action的时候才操作

-

瞬时性

- 用时才产生,用完就释放