刚在研究 Python 爬虫的时候,看到了个小白工具,叫 Web Scraper,于是来测试下好不好用。

Web Scraper 是什么?

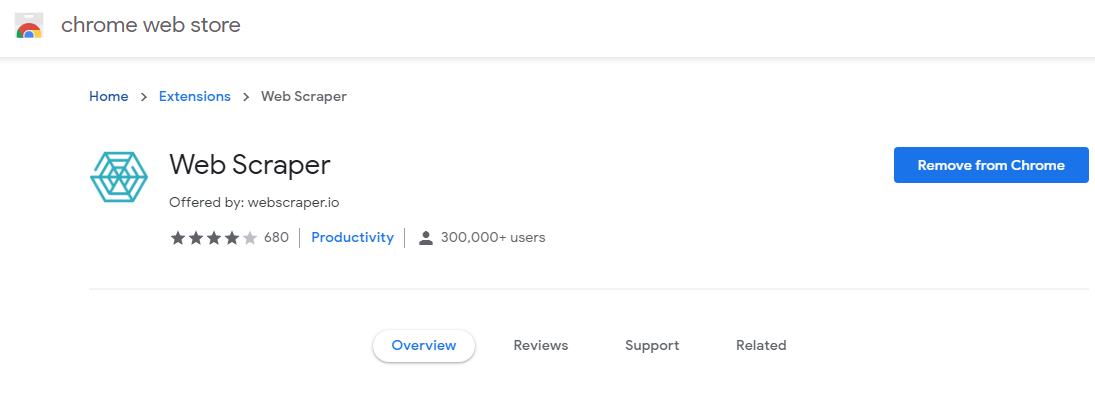

它是一个谷歌浏览器的插件,

用于批量抓取网页信息,

主要特点为,小白操作,快速上手

安装方法

去 Google WebStore 里面搜,Web Scraper,然后点击安装就行了!

使用方法

自己上网搜吧,太多了!

测试结果

-

首先,它适用的范围是,网页的可见范围;就是页面上能看到的,都可以抓取。

- 所以,工作范围有限;

- 例如,当你有一个 Excel,里面有 50 只股票的名字,要找到股价,这时这个工具就做不了了,

- 因为股票代码,在Excel里,不在网页上。

- 这种情况,需要用 Python 自己写个小爬虫,来完成!

- 所以,工作范围有限;

-

然后,测试了抓取的精准度

-

发现,抓取的时候,插件不会把网页往下拉。

- 在测试抓去一个页面的,70多个视频标题,的时候,不知为何只能抓取出20多个

- 可能是因为,这个页面每次久显示20个,然后当手动拉到最底端的时候,才会再 Load 例外20个。而,这个 Scraper,好像不会去拉动页面,只是打开就抓取,所以页面其实只 Load 了20个视频。

- 这是插件的局限性么?

-

再者,若是一个页面有很多信息要抓取时,会很不准确。

- 如果一个页面,只有一个 Selector,只抓取一个 Element,会相对准确

- 例如,当一个人网页有大量新闻的时候,需要抓取所有的,标题,作者,时间;

- 这样需要在一个页面上,同时建立3个 Selector,来抓取3列数据。测试结果,抓去数据严重不全,基本没用。

- 而当一个页面,只有一个 Selector,只抓取一个 Element 的时候,就会比较精确。

-

最后总结

测试结果差不多就这么多,遇到了我这样的用户,这软件基本被扒了层皮。

觉得,这个插件更适合,小白,和相对简单的抓取任务。