最近在Udacity上学习Machine learning课程,对于验证集、测试集和训练集的相关概念有些模糊。故整理相关资料如下。

交叉检验(Cross Validation)

在数据分析中,有些算法需要利用现有的数据构建模型,比如贝叶斯分类器,决策树,线性回归等,这类算法统称为监督学习(Supervisied Learning)算法。构建模型需要的数据称之为训练数据(Train Data)。

模型构建完后,需要利用数据验证模型的正确性,这部分数据被称为测试数据(Test Data)。测试数据不能用于模型构建之中,只能用于最后检验模型的准确性。

训练数据,验证数据和测试数据

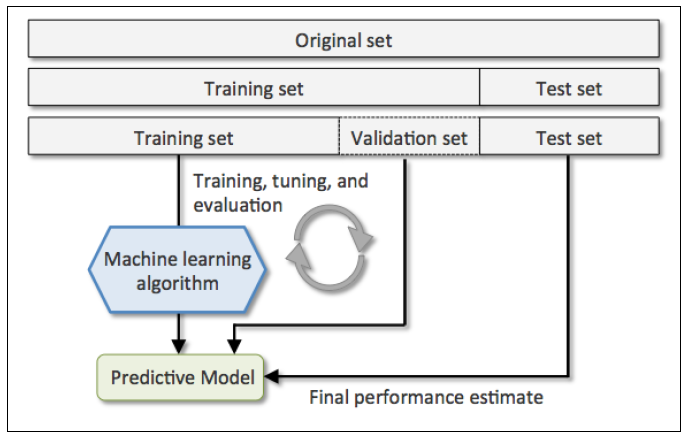

一般做预测分析时,会将数据分为两大部分。一部分是训练数据,用于构建模型,一部分是测试数据,用于检验模型。但是,有时候模型的构建过程中也需要检验模型,辅助模型构建,所以会将训练数据在分为两个部分:1)训练数据;2)验证数据(Validation Data)。验证数据用于负责模型的构建。典型的例子是用K-Fold Cross Validation裁剪决策树,求出最优叶节点数,防止过渡拟合(Overfitting)。下面形式的描述一下前面提到的3类数据:

- 训练数据(Training Data):用于模型构建

- 验证数据(Validation Data):可选,用于辅助模型构建,可以重复使用。

- 测试数据(Test Data):用于检测模型构建,此数据只在模型检验时使用,用于评估模型的准确率。绝对不允许用于模型构建过程,否则会导致过渡拟合。

一图顶千字

K折交叉检验(K-Fold Cross Validation)

K折交叉检验的大致思想是将训练集大致分为K个子样本,每次取一个样本作为验证数据,取余下的K-1个样本作为训练数据。模型构建后作用于验证数据上,计算出当前错误率。重复K次,将K次错误率平均,得到一个总体的错误率。可以通过整体错误率,估计当前整体数据用于建模的错误率。

举个例子,K = 10(常见情况),求出总体错误率为8.7%。那么将当前的所有数据全部作为训练数据,得到的模型的错误率90%的可能在9.7%左右。

参考资料

交叉验证Wiki:http://zh.wikipedia.org/wiki/交叉驗證

Data Analysis on Coursera:https://class.coursera.org/dataanalysis-001/forum/thread?thread_id=2901

bourneli博客 https://www.cnblogs.com/bourneli/archive/2013/03/11/2954060.html